Publicamos un eBook de 78 páginas en ingles y 3 videos sobre mejores prácticas en MLOps en Databricks.

Aquí puedes encontrar el eBook:

Aquí tienes los 3 videos:

Videos 1 y 2

¿Qué es MLOps?

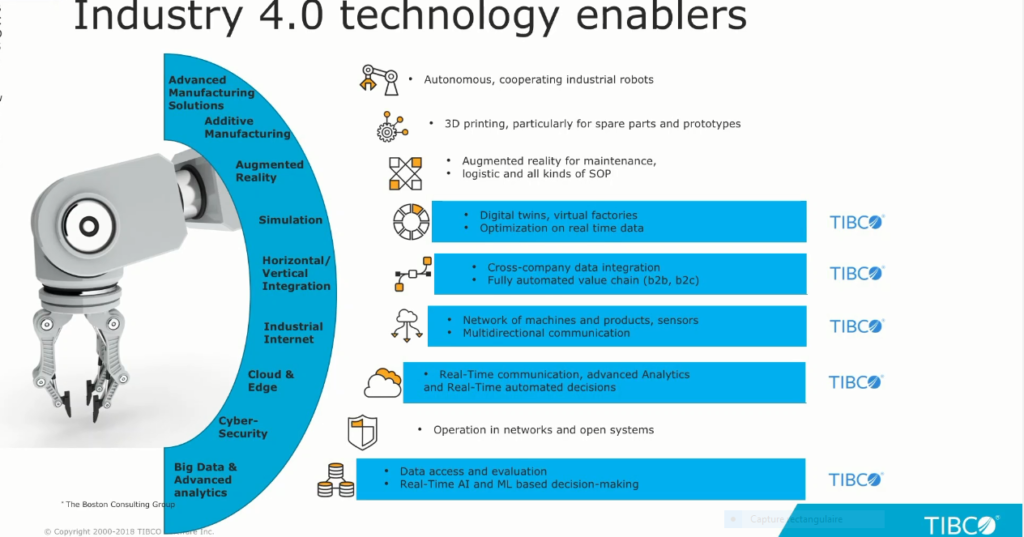

MLOps significa “Machine Learning Operations”. Es un campo en rápida evolución que se centra en la creación y el mantenimiento de flujos de trabajo sólidos, flexibles y eficientes para gestionar el ciclo de vida completo de los modelos de aprendizaje automático (ML), desde la creación hasta la producción y el monitoreo. En esencia, MLOps busca mejorar la estabilidad del rendimiento y la eficiencia a largo plazo de los sistemas de ML.

Se puede considerar como la combinación de DataOps, DevOps y ModelOps, que gestionan los datos, el código y los modelos, respectivamente, para crear soluciones de IA. El objetivo principal es acelerar el tiempo de entrega de modelos a la producción y reducir la necesidad de supervisión manual continua, permitiendo a los equipos de ciencia de datos enfocarse en nuevos proyectos.

Herramientas como Databricks ofrecen componentes que simplifican el proceso MLOps, incluyendo la gestión de datos y modelos (Unity Catalog), el despliegue de modelos en tiempo real (Model Serving), y el monitoreo (Lakehouse Monitoring).

Ultra resúmen del eBook “The Big Book of MLOps”

Este libro electrónico de Databricks proporciona una arquitectura de referencia actualizada para MLOps, incluyendo nuevas características como Unity Catalog y Model Serving, y guía la implementación de aplicaciones de IA generativa, especialmente LLMs.

Principales puntos que se tocan

- El libro describe una arquitectura de referencia actualizada para MLOps en Databricks, incorporando Unity Catalog y Model Serving.

- Se destacan las ventajas de Unity Catalog para la gestión unificada de datos y modelos, incluyendo control de acceso, auditoría y linaje.

- Se explica Databricks Model Serving como una solución serverless para la implementación de modelos en tiempo real, simplificando el despliegue y mejorando la escalabilidad.

- Se introduce Databricks Lakehouse Monitoring para el monitoreo de datos y modelos, facilitando la detección de errores y la realización de análisis de causa raíz.

- Se discuten las decisiones de diseño para la organización de datos y activos de IA en Unity Catalog, considerando aspectos como la eficiencia, escalabilidad y gobernanza.

- Se presentan patrones de implementación de modelos en tiempo real, como pruebas A/B y despliegues graduales, utilizando Model Serving.

- Se aborda LLMOps, incluyendo prompt engineering, RAG, y fine-tuning de LLMs, además de estrategias para gestionar las compensaciones entre costo y rendimiento.

Resúmen amplío del eBook

El libro electrónico “El Gran Libro de MLOps – 2ª Edición” proporciona una guía completa sobre las operaciones de aprendizaje automático (MLOps), incluyendo una nueva sección sobre LLMOps (operaciones para modelos de lenguaje grandes). El libro comienza recapitulando los puntos clave de la edición anterior, enfatizando la importancia de una estrategia efectiva de MLOps para acelerar el tiempo de valor comercial y liberar a los equipos de ciencia de datos de la supervisión manual continua de los modelos en producción . Se destaca el principio rector de adoptar un enfoque centrado en los datos para el aprendizaje automático, considerando que todas las partes de un proyecto de ML son, en esencia, canalizaciones de datos .

Se explica la semántica de los entornos de desarrollo, ensayo y producción, con cada uno teniendo controles de acceso y garantías de calidad distintas . Se detallan los patrones de implementación de modelos de ML, recomendando el enfoque “implementar código”, donde el código se mueve a través de las etapas de desarrollo, ensayo y producción .

La segunda edición presenta nuevas características de Databricks que impactan la arquitectura de referencia de MLOps. Unity Catalog, unifica la gobernanza y seguridad de datos y modelos de ML, facilitando el acceso de lectura a los activos de producción desde el entorno de desarrollo . Esto permite a los científicos de datos entrenar modelos usando datos de producción, acelerar el desarrollo y mejorar la calidad de los modelos . Se describe la organización de datos y activos de IA en Unity Catalog, usando un esquema de tres niveles (catálogo, esquema, entidad) para una mejor eficiencia, escalabilidad y gobernanza . Se ofrecen recomendaciones sobre la organización de estos activos, considerando el tamaño del equipo, la complejidad del proyecto y los niveles de acceso . Se propone una estructura de organización de ejemplo con catálogos “dev”, “staging” y “prod”, y un esquema por caso de uso (T47]({}) ).

Databricks Model Serving simplifica la implementación de modelos de ML en tiempo real como una API , mientras que Lakehouse Monitoring proporciona una solución de monitoreo centrada en datos para asegurar la alta calidad de los activos de datos e IA . Ambas herramientas se integran con Unity Catalog y MLflow .

El libro describe las decisiones de diseño para la arquitectura MLOps, incluyendo el testing previo al despliegue para modelos en tiempo real , los patrones de implementación de modelos en tiempo real (A/B testing, despliegue gradual, despliegue sombra) , y cómo implementar estas estrategias en Databricks . La arquitectura de referencia propuesta utiliza un flujo de trabajo de “implementación de código” con un mapeo 1:1 entre entornos y Unity Catalog . Se detalla el proceso paso a paso de mover el código a través de los tres entornos, incluyendo desarrollo, pruebas (con pruebas unitarias e integración), fusión de código, creación de una rama de lanzamiento, entrenamiento y validación del modelo, implementación del modelo, inferencia y monitoreo . También se incluye información sobre la implementación de MLOps en Databricks usando MLOps Stack .

Finalmente, el libro explora LLMOps, centrándose en la producción de modelos de lenguaje grandes (LLM). Se discuten los cambios que los LLMs traen a las prácticas de MLOps, incluyendo la ingeniería de prompts , el aprovechamiento de datos propios (ingeniería de prompts, RAG, ajuste fino, preentrenamiento) , la evaluación de modelos (incluyendo el uso de LLMs como evaluadores y la retroalimentación humana) , el empaquetado de modelos y canalizaciones para la implementación , la inferencia LLM (tiempo real y por lotes) , la gestión de las compensaciones entre costo y rendimiento y una arquitectura de referencia modificada para aplicaciones basadas en LLM . El libro concluye reiterando la importancia de MLOps y LLMOps para liberar el potencial de la IA, destacando el rol de Databricks como plataforma unificada para ambos.